Acusado de ter cometido um assassinato em nome do tribunal do crime do PCC, Marcos Libório Carneiro, 32, pediu à Justiça para usar o ChatGPT no seu julgamento.

O crime ocorreu na madrugada de 19 de janeiro de 2022 no Capão Redondo, na zona sul de São Paulo. Carneiro e um comparsa, de acordo com a denúncia apresentada pelo Ministério Público, teriam matado um usuário de drogas após ele ter revelado para a polícia a localização de um ponto de tráfico.

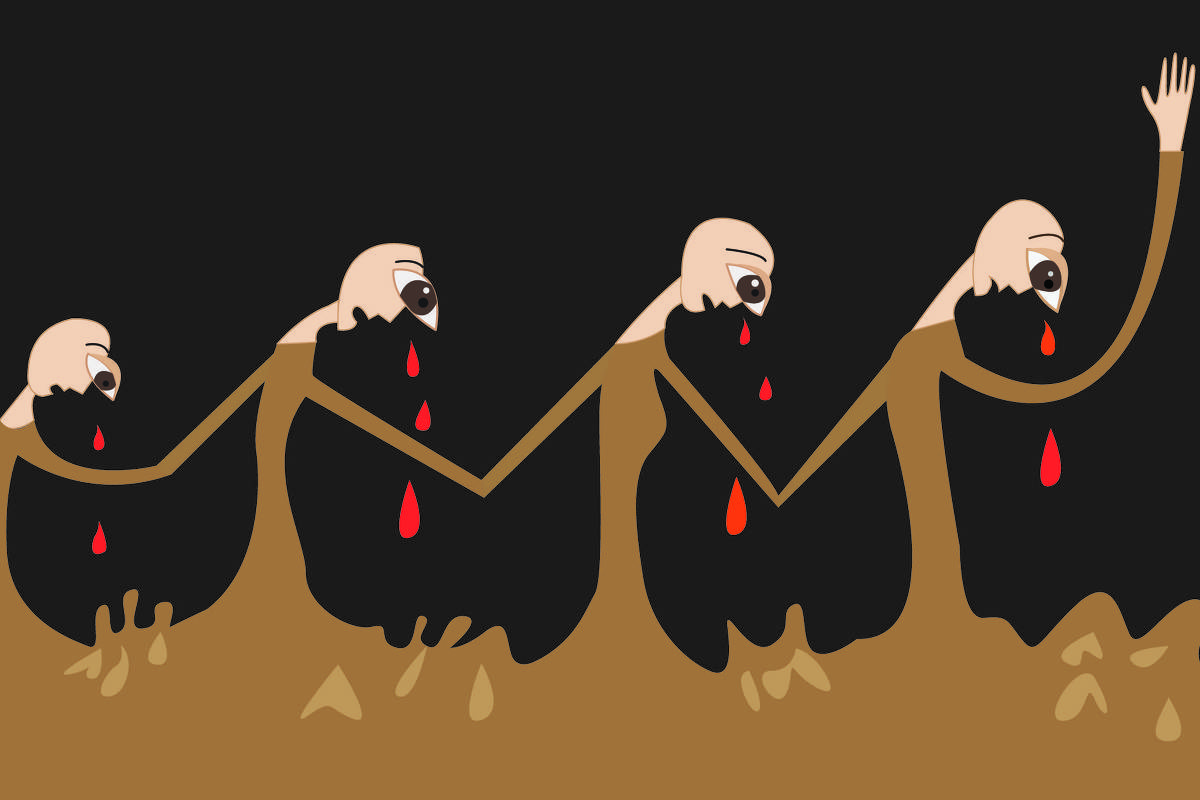

Segundo a acusação, os dois indiciados e outras pessoas não identificadas teriam “subjulgado” o usuário de drogas em uma mata. Aos gritos de “é isso que você vai ganhar caguetando a biqueira”, a vítima recebeu tapas nas costas e, em seguida, foi colocada de joelhos em uma cova, onde teve seu pescoço cortado com um facão.

A acusação foi feita com base no relato de uma testemunha que estava na mata usando drogas e que disse ter se escondido quando viu cerca de dez homens armados se aproximando. “Eles mataram, enterraram e foram embora.”

Dias depois do crime, ele encontrou uma viatura e contou o que havia presenciado.

Carneiro, que nega ter cometido o crime, pediu à Justiça para usar a inteligência artificial no Tribunal do Júri com o objetivo de derrubar o testemunho.

“O acusado Marcos não tem qualquer ligação com o caso”, afirmou à Justiça o advogado Paulo Patriota Mendes, que o representa. Segundo ele, é “surreal” acreditar que a testemunha tenha tido “condições de reconhecer outra”.

Com o ChatGPT, o advogado entende que poderá usar as fotografias do laudo pericial para mostrar, a partir da perspectiva da testemunha, a dificuldade de enxergar os acontecimentos. “A visualização era a de uma pessoa sob efeitos de drogas (crack), em meio a um matagal, de madrugada, distante no mínimo 50 metros do local, com mais de 10 pessoas praticando o ilícito, as quais estavam com lanternas de celulares acesas”, afirmou à Justiça.

A juíza Isabel Rodrigues rejeitou o pedido. “Como se sabe, o ChatGPT é modelo de linguagem que, muitas vezes ‘alucina’, criando fatos e mesmo decisões judiciais inexistentes, de modo que sua utilização diretamente durante a sessão pode ensejar a apresentação, aos jurados, de informações equivocadas, influenciando indevidamente o julgamento”, afirmou na decisão.

Segundo a magistrada, as ferramentas de inteligência artificial “devem sempre ser submetidas a cuidadosa revisão pelo usuário, o que não seria possível caso utilizada em tempo real, a tornar incabível seu uso na forma pretendida”.

O advogado recorreu da decisão, mas os desembargadores do Tribunal de Justiça ainda não analisaram o pedido.

FolhaJus

A newsletter sobre o mundo jurídico exclusiva para assinantes da Folha

Fonte ==> Folha SP